![[PukiWiki] [PukiWiki]](image/logo.png)

電気通信大学 明・佐藤研究室 |

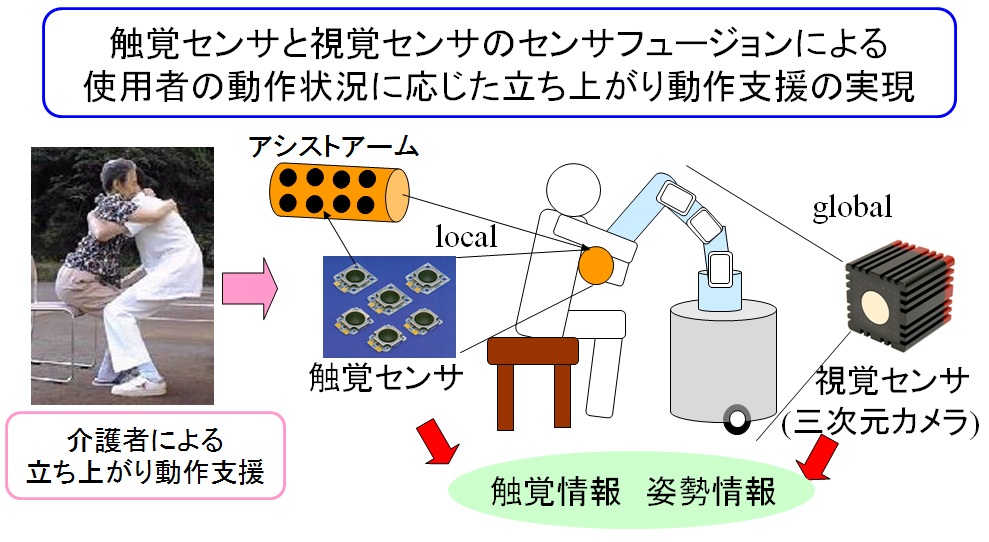

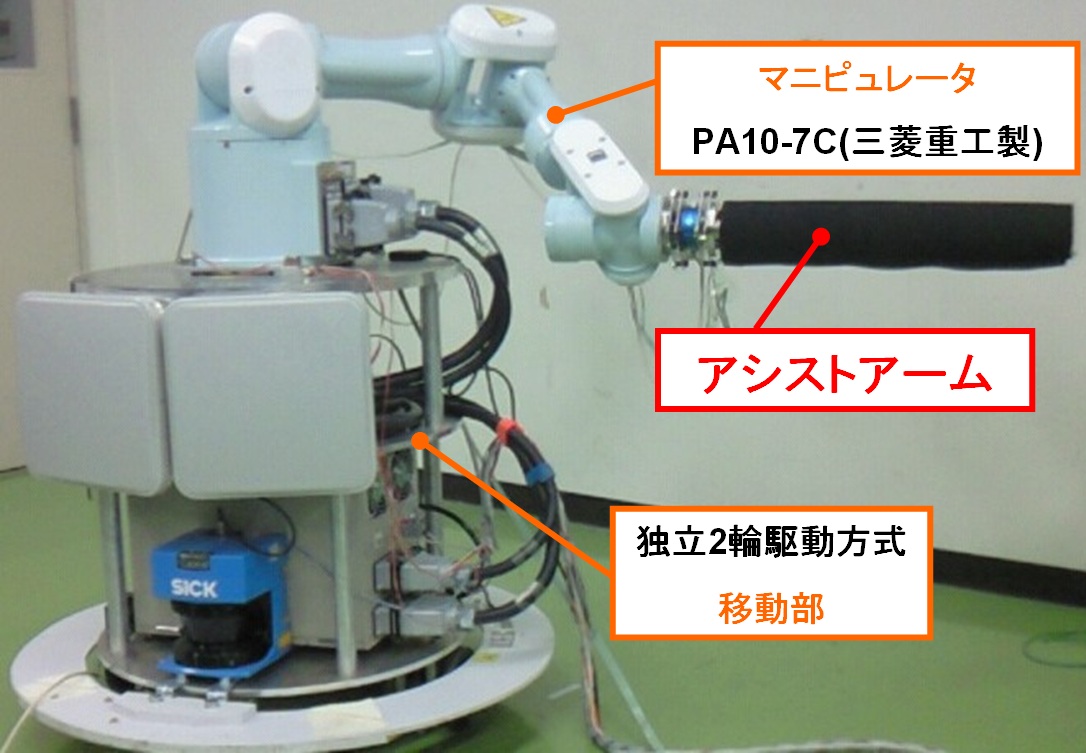

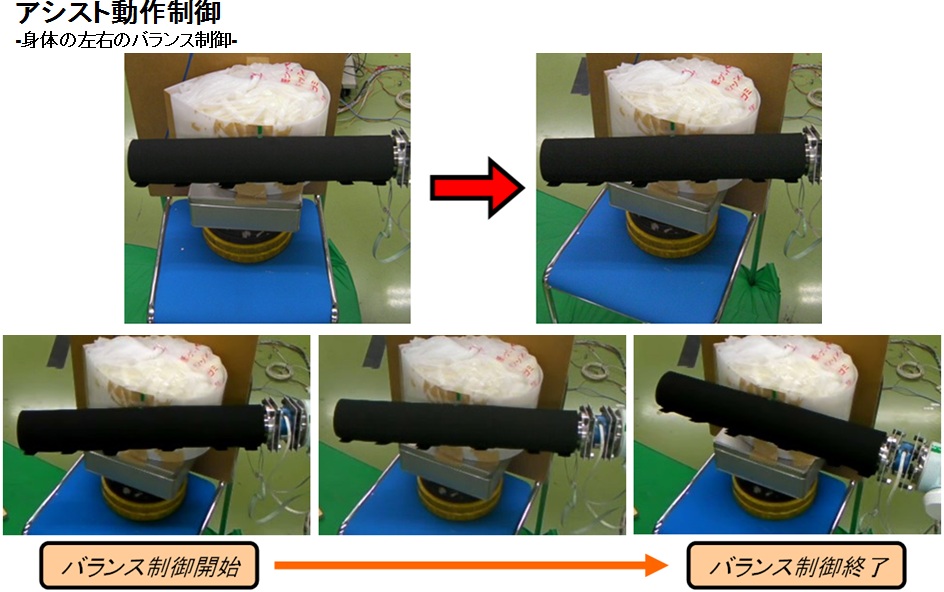

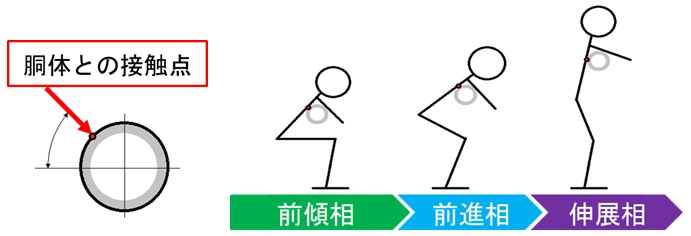

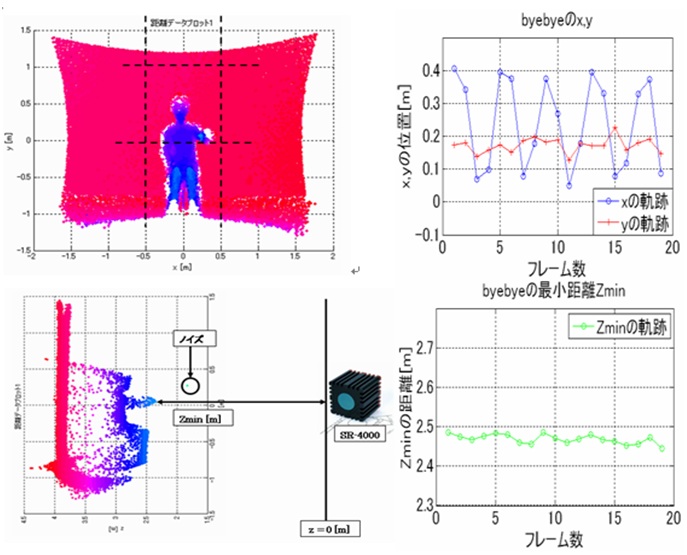

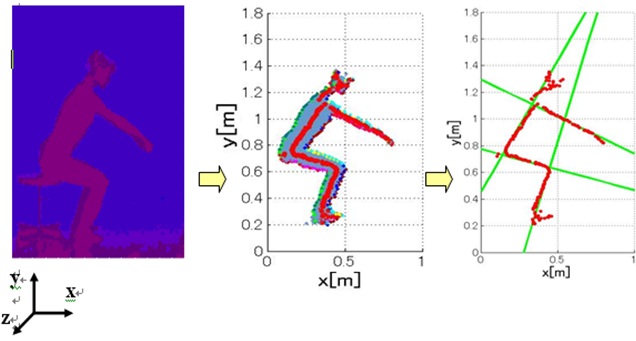

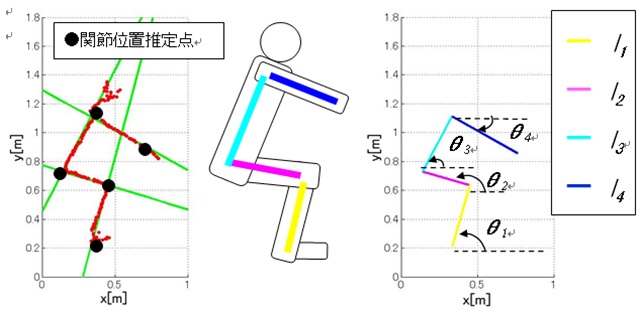

移動マニピュレータによるヒューマンアシストに関する研究非健常者の立ち上がり動作アシスト近年,少子高齢化社会による労働力不足が懸念される中,家庭内労働ロボット,いわゆるホームサービスロボットの必要性が認識され始めています.本研究室では,移動マニピュレータによるホームサービスの一環として,移動マニピュレータのアームを覆う離散型高速触覚(CoP) センサと,3 次元距離測定カメラを用いて,リアルタイムフィードバック制御により,非健常者の動作アシストを安心・安全かつ適切に実現することを目指しています. 移動マニピュレータ本研究室で用いる移動マニピュレータとは図 2に示す独立2輪駆動方式で操舵する移動部をベースにしており,その上にマニピュレータとして三菱重工製汎用ロボットアームPA10-7C を搭載したものです. アシストアーム立ち上がり動作のアシストを行う際に,人が脇下に入れて掴まるアームの部分(以下, アシストアームと呼ぶ) には触覚センサを搭載しています.本研究では触覚センサとして離散型CoPセンサを採用しました.立ち上がり動作のアシスト中はアシストアームに被介助者が直接触れているため,立ち上がりアシスト中の被介助者がアームにしっかり掴まっているか,立ち上がり動作が行えているか,そして立ち上がり動作のどの段階にきているかといった情報を得ることが出来ます.そこで,アシストアームのCoPセンサ配置は左腕,右腕,胴体部の3箇所として,各部分のCoPセンサの出力(荷重中心位置と総荷重)を計測しています. 離散型CoPセンサ離散型CoPセンサはあらゆる自由曲面上にネットを被せるように触覚センサを配置することが可能であり, 配線はセンサ素子数によらず4本で済みます.またソフトウェアによる処理を必要としない高速な応答速度(1[ms] 以下) を持っています.そしてセンサの2次元表面に加わる荷重分布の中心位置とその総荷重を検出することができ, 安価であるという特長を持っています. 身体の左右のバランス制御人がアシストアームに掴まっているときに長手方向の荷重中心位置が変化した場合,それは人とアームの間で転がり運動が起こったと考えられます.このまま支援を行うと転倒の恐れがあるので,長手方向の荷重中心位置がアシストアームの中心に来るように,アームを制御して転がり運動を行わせる必要があります.この実験の際,安全上のため,人の代わりに人体の体幹を模した楕円形物体を作成して行いました.結果は図の通り,はじめ体の中心から外れていたアームは制御終了時には中心に戻っていることを確認しました. 立ち上がり支援軌道の生成人がアシストアームに掴まっているときに円周方向の荷重中心位置の出力を読み取ることで図のような立ち上がり状況の推定を行っています.人がアシストアームに掴まって立ち上がる際の円周方向の荷重中心位置を計測した実験から図のような変化があることがわかりました.前傾層から前進相にかけては円周方向の荷重中心位置が上方へ遷移し,前進相から伸展相にかけては円周方向の荷重中心位置が下方へ遷移していきます.この情報から姿勢や状態を推定し,支援軌道をファジィ制御によって修正しながら支援を行っています.動画では,安全上のため人の代わりに人体を模した人形を用いて,立ち上がりのアシストを行っています. 3次元距離測定カメラ本研究室で用いる3次元距離測定カメラとは図に示す赤外線TOF方式3次元距離測定カメラ「SwissRanger SR-4000」です. SR-4000 は,TOF 原理に基づいて動作するカメラです.このTOF とは「Time-of-Flight method(飛行時間計測方式)」の略であり,前面のLED より強度変調して発光された赤外線が対象物体で反射して戻ってくるまでの時間を計測することで,物体までの距離を取得するというものです. 人間動作の認識本研究室ではSR-4000を使った研究として,人間動作の認識を行っています. その中の一つであるジェスチャ認識は図8に示すように,手の動きを特徴としてx,y,z方向に描いた軌跡からジェスチャを判別しています.例として図にはbyebyeジェスチャの軌跡を示しています. ジェスチャ認識とは別に人間の立ち上がり動作中の姿勢認識を行なっています.姿勢認識方法として,まず取得した距離画像データ(図9左)からエッジパターン抽出により特徴点(図9中央)を抽出し,そしてLMedSハフ変換を用いて人体の骨格線(図9右)を抽出しています.これらの骨格線から関節位置(図10左)を推定し,さらにそこから関節角度および部位長さの推定(図10右)も行っています. これからの研究の展開触覚センサ,視覚センサのセンサフュージョンにより非健常者の動作アシストを安心・安全かつ適切に行えるよう研究を進めていきます. また,視覚センサとしてマイクロソフトより発売されたKinectの使用も検討しています. Kinectは左図に示すデバイスで3次元画像とRGB画像を同時に取得することができ,安価であるという特徴を持っています.また,人間動作の認識が容易に行えるライブラリが提供されており,右図のように人間の姿勢認識を簡単に行うことができます. |